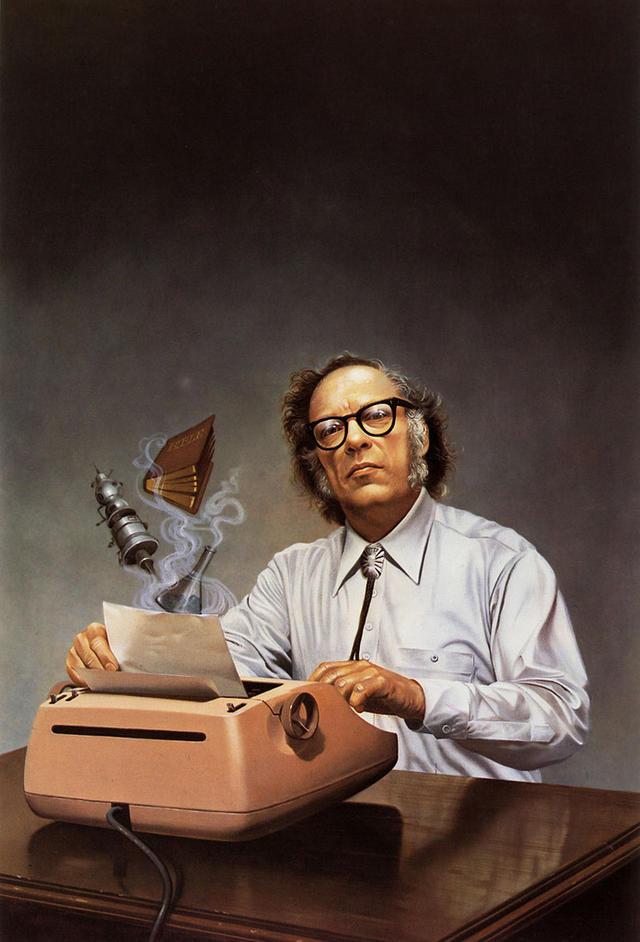

(文/George Dvorsky)70年前,阿西莫夫提出他著名的机器人三定律,来保证机器人会友善待人。虽然最早提出时这只是个文学手法,但是有些人认为这些定律是现成的方案,能挽救我们免于机器末日。那么,阿西莫夫的安保措施成功经历了时间的考验吗?专家的回答是,没有。

1942年,阿西莫夫在短篇小说"Runaround"(《环舞》)中首次提出了三定律:

一 机器人不得伤害人类,或因不作为使人类受到伤害。

二 除非违背第一定律,机器人必须服从人类的命令。

三 除非违背第一及第二定律,机器人必须保护自己。

但后来,阿西莫夫加入了一条新定律:第零定律。

零 机器人不得伤害人类整体,或因不作为使人类整体受到伤害。

阿西莫夫的科幻设定里,机器人三定律是植入到近乎所有机器人软件底层里,KUKA机器人电路板维修,不可修改不可忽视的规定,绝不仅仅是“建议”或者“规章”。但是显然这不是一个物理定律,所以现实中的机器人并不遵守——至少暂时如此。

正如阿西莫夫许多小说里显示的,这三条定律的缺陷、漏洞和模糊之处不可避免会导致一些奇怪的机器人行为。比方说,www.zr-kuka.com,这三条定律连何为“人”、何为“机器人”都没有良好定义。而且,如果机器人获取的信息不完整,它们完全可以无意中打破定律。更何况,你要怎么阻止一个智力超群的机器人自己把定律改掉呢?

因此,机器人维修,很多人都认为这只是单纯的推动剧情用的写作手法而已。但是,1981年,阿西莫夫本人在《Compute!》里说:

“……有人问,我是不是觉得我的三定律真的可以用来规范机器人的行为——等到机器人的灵活自主程度足以在不同的行为方式中选择一种的时候。我的答案是,‘是的,三定律是理性人类对待机器人(或者任何别的东西)的唯一方式’。”

好吧,三十年过去了,我们的机器人——准确地说,是操纵机器人的人工智能——真的在逼近阿西莫夫所说的那一天。事实上,人工智能恐怕再过一段时间就要抵达技术奇点,发生爆炸式增长,彻底把人类智能甩在后面。

而如果这样一个超级智能的程序编得不够好,或者它不在乎人类的需求,那么对我们而言就是彻头彻尾的灾难。我们必须保证它是安全的。

那么,阿西莫夫三定律可以帮我们吗?我们采访了两位人工智能理论研究者:本·格策尔(Ben Goertzel),艾迪亚金融预测公司首席科学家;路易·海尔姆(Louie Helm),机器智能研究所代理主任。他们的观点是,阿西莫夫三定律完全不能胜任——而如果我们想保证超级智能的安全,我们需要一些全然不同的东西。

阿西莫夫的未来

“我认为阿西莫夫预想的机器人过不了多久就会实现。”格策尔说,“但是在他大部分小说里,看起来人类级别的机器人好像就是机器人学和AI工程的顶峰了。事实看起来并非如此。在抵达阿西莫夫式类人机器人之后,很快超人AI也会成为可能。”

典型的阿西莫夫未来里,大部分生活都如常——只不过多了些人形智能机器人走来走去而已。“但这种未来不太可能实现——或者就算是它实现了,也只会存在很短的时间,”他说。

在海尔姆看来,机器人根本无关紧要。

“我认为对人类来说最主要的问题,不是一大群半智能人形机器人所需的道德规范,而是高阶人工智能最终会出现(不管有没有躯体),其功能远远超过人类水平。”海尔姆说,“人类早晚必须要跨过超级智能这个坎。这也是为何开发安保措施如此重要。在我看来,机器人、仿生人、模拟大脑什么的都无关紧要,我们最多和它们相处一二十年,之后就要面对真正的大问题——为超级智能开发伦理道德。”

好的开端?

鉴于阿西莫夫三定律是第一个真正试图解决人工智能行为问题的方案,那么就算是超级人工智能,它能不能也起到一定效果——或者至少有所启迪呢?

“老实说,我真没从机器人三定律里获得什么灵感。”海尔姆说,“机器伦理学的共识是,它无法成为机器伦理的合适基础。”三定律的确广为人知,但现实中无论是AI安全研究者还是机器伦理学家,都没有真的使用它作为指导方案。

“原因之一是这套伦理学——我们称之为‘义务伦理学’(deontology)——作为伦理基础是行不通的。依然有几个哲学家试图修复义务伦理学体系,但同一批人常常也热衷于‘智能设计’或者‘神命论’之类的东西。”海尔姆说,“没几个人严肃对待他们。”

他总结了三定律的几处缺陷:

内在的对抗性

基于有缺陷的伦理框架(义务伦理)

不被研究者接受