2019年9月,美国众议院监督和政府改革小组委员会(House Oversight and Government Reform Subcommittee)信息技术组主席Will Hurd和首席成员Robin Kelly签发了题为《Rise of the Machines—Artificial Intelligence and its Growing Impact on U.S. Policy》(机器崛起:人工智能及对美国政策不断增长的影响)的AI白皮书。

文中小组委员会总结了关于人工智能监督和听证会的经验教训,并提出了前瞻性的建议。小组委员会分析了在AI应用方面面临的挑战,文中主要关注失业、隐私、偏见和恶意使用4个问题领域并提出了针对性建议。

现由学术plus编译全文,仅供参考。

文章版权归原作者所有,观点不代表本机构立场。

机器崛起:人工智能及对美国政策不断增长的影响

作者:plus评论员 张涛

来源:https://oversight.house.gov

一、AI所面临的挑战

众议院监督和政府改革小组委员会的听证会得出结论,AI面临不同种类的挑战。本文主要解决听证会提出的以下问题。

1、劳动力(失业问题)

一个重要问题就是AI驱动的自动化可能会导致失业。2017年12月,麦肯锡的报告称由于AI驱动的自动化,美国和德国大约有1/3的劳动力可能需要找新的工作。2013年牛津大学一份研究称AI技术对美国劳动力的影响可能更高,大约有47%的美国人面临失业的风险。除此之外,AI还有可能带来财富不平等的问题。

但听证会和其他研究表明,AI也有改善和增加工作机会的空间。比如,经济合作与发展组织(Organisation for Economic Co-operation and Development,OECD)2019年3月的一份报告就称OECD成员国有14%的工作面临自动化的风险。

所有这些研究的共同点是在指定经济政策时必须考虑到美国人在采纳人工智能技术的同时所面临的不确定的工作前景,以及需要增加对教育和工人再培训方面的投资。因此,应鼓励联邦、州和地方政府与教育工作者、雇主、雇员、工会和其他利益相关者合作,制定有效的战略以改善美国工人的教育、培训和再培训,使其在人工智能驱动的经济中更具竞争力。联邦政府也应该以身作则,KUKA机器人维修,在教育和培训方面投入更多,使其现有和未来的劳动力获得必要的人工智能技能。

2、隐私

AI技术依赖于算法,而算法需要大量的数据来决定如何响应这些新的输入。因为AI技术需要大量的数据,因此听证会中多次将个人隐私视为潜在挑战。例如,人工智能专家Ben Buchanan博士就消费者数据用在人工智能系统中所面临的各种隐私风险进行了证明。这些数据有被黑客窃取的风险,也有可能被收集或有权限访问的人滥用以及二次使用的风险。

2017年美国最大的征信机构Equifax数据泄露事件就应证了研究人员的担忧。黑客成功入侵了系统后,获取了大约1.45亿美国公民个人数据的访问权限。这些数据包括Equifax收集的用户敏感信息,www.zr-kuka.com,有社会安全码、生日、地址、驾驶证号等。

涉及隐私问题的另一个例子是智能音箱(即使用基于语音的数字助理)。智能音箱为了能够响应用户的命令,需要随时监听,那么非命令期间听取的数据怎么办呢?执法部门已经开始要求科技公司为刑事案件录音。但这也提出了一个新的问题,即如何使一直处于监听状态的设备做到收集消费者的证据呢?

为了解决人工智能驱动的技术带来的各种隐私挑战,Buchanan博士称企业需要在人工智能系统的设计和开发中采取更严格的保障措施。但消费者技术协会主席Gary Shapiro认为针对不同的AI应用应该有不同的管理方式,而不能将所有的AI应用放在同一个AI隐私管理规范之下。一些人工智能产品和应用程序可能已经受到了联邦隐私法或联邦贸易委员会的约束,例如健康保险流通与责任法案(Health Insurance Portability and Accountability Act)、儿童在线隐私保护法案(Children’s Online Privacy Protection Act)、Gramm-Leach-Bliley法案。

随着人工智能系统和应用程序越来越多地收集和使用个人数据,更加引起人们对隐私问题的担忧。因此,联邦机构应审查联邦隐私法律、法规和司法判决,以确定它们如何已经适用于其管辖范围内的AI产品,并在必要时更新现有法规(加入AI的管理内容)。

3、偏见

人们越来越依赖AI技术来做出关于个人的决策,这也加剧了人们对这项技术准确性的担忧,特别是在政府使用该技术时。电子隐私信息中心(EPIC)在向小组委员会发表的一份声明中解释道:“当政府使用AI来制定关于人们的决策时,增加了关于问责制、正当程序和公平性的基本问题。”

AI非常依赖数据。如果数据本身是不完整的、存在偏见或存在其他形式的偏差, AI系统就可能存在不准确的风险。由于AI系统依赖于越来越大量的数据,包含偏见(差)的数据集可能会增加风险。如果AI系统是通过有偏见数据训练的,那么AI系统产生的结果应该是有偏见的。

比如,2016年ProPublica调查了一些法院使用“风险预测工具”用于刑事判决和保释听证会的情况。调查结果显示算法和系统是有偏见和不准确的。非洲裔美国人被标记为高风险的人数是白人的两倍,但这些被标记为高风险的非洲裔美国人之后并没有再犯罪。随着AI技术应用于金融、法律、医疗等行业,这些偏见可能会被AI技术放大,最后给人们带来伤害。

听证会上,其他利益相关方也明确指出,解决AI系统中的偏见或潜在偏见的最有效方法之一就是提高这些系统使用的透明度:

AI系统应该是可检查的。算法用于构建模型的数据应该是适宜的。算法做出的决策应当是可检查的。换句话说,当我们使用这些算法时,应该要能够解释每个算法的输出。

解决AI中的偏见的解决方案也是跨领域的。例如,埃森哲最近推出了一种“AI fairness tool(人工智能公平工具)”,该工具使用AI来检查数据如何影响模型中的变量,如年龄、性别和种族等。人工智能相关的非政府研究机构也在研究AI偏见和人工智能。简而言之,解决AI系统中的偏见和潜在偏差将需要在这些系统做出有关个人的相应决策时提高透明度。

联邦、州和地方机构在使用AI系统做出相应决策时应确保支持这些系统的算法是可审计和可检查的。此外,鼓励联邦、州和地方政府更积极地与学术机构、非营利组织和私营企业合作,讨论如何识别人工智能系统中的偏见,以及如何通过技术更好地消除偏见和如何解释偏见。

4、AI的恶意使用

听证会还强调了预防AI的恶意使用的必要性。OpenAI 2019年初发布的一份报告称,除非制定足够的防御措施,否则人工智能的进展将导致网络攻击“更有效、更有针对性、更难以追溯、AI系统中的漏洞也更可能利用”。该报告的结果与网络安全公司Cylance 2017年的调查结果一致。Cylance的调查显示, 62%的信息安全专家认为,人工智能将于明年被用于网络攻击中。

AI的计算能力使其能够以指数级增加网络攻击的严重性。AI恶意使用特别值得特别关注的三个方面是:政治安全、物理安全和数字安全。这三个领域之间的共同主题是AI扩大了风险等级。比如,网络攻击可以在一瞬间影响更多的设备、人和企业,从而破坏数字安全。事实上,美国已开始使用AI应对网络攻击。

比如过去几年俄罗斯发起的虚假信息宣传活动。有了AI技术的推动,含有“deepfake”技术伪造的视频的“假新闻”可能会更容易让人相信。通过数据AI可以精确地识别那些最易受到虚假信息影响的人。这种能力可能会极大扩大敌对民族国家破坏另一个国家政治体系的虚假宣传活动中受影响的人数。

→Deepfakes变脸术 竟成为美国国家安全的新威胁

AI系统也可能危及物理安全。例如,来自美国大学的一组研究人员展示了黑客如何通过一些简单的贴纸使自动驾驶车辆错误识别路标,而这些贴纸本是无害的。

在考虑未来如何积极利用AI时,政府还必须考虑该技术被用于伤害个人和社会的情况,并为如何减轻这些危害做好准备。

二、政府如何回应AI?

一般来说,美国政府对新兴技术采取不干涉方式。比如,在20世纪90年代,政府对互联网的首选政策是支持私人行动而不是采取公共监管。在此期间,虽然国会和州立法机构通过了若干关于商业、内容和竞争的法律,但都侧重于为新兴网络制定合理的上层建筑,而不是对其发展进行微观管理。克林顿政府采取了“有益忽视(salutary neglect)”的政策,克林顿总统命令政府“不做任何破坏新兴技术提升普通美国人生活的能力的事情”。

小组委员会的建议是联邦政府对任何潜在的人工智能进行监管应该考虑上述历史。政府应该首先评估对公共安全或消费者带来的风险是否适用于现有的监管框架,如果是,应考虑现有框架是否能够充分应对带来的风险。如果这些风险超出现有的监管框架,则应谨慎考虑是否需要修改或增加以更好地应对人工智能带来的风险。

在广泛认可的衡量AI产品和应用安全和网络信息安全的标准应该优先于新的监管措施。一个共同的分类方法也有助于提高清晰度,并能够准确计算人工智能的技能和用途。美国国家标准与技术研究院(NIST)是制定标准的关键角色,IEEE(电气和电子工程师协会)关于自主和智能系统伦理的全球倡议也起着重要的作用。人工智能指数(AI Index)是斯坦福大学“人工智能百年研究”的一部分,收集了有关人工智能的数据以衡量其进展,这对于提供历史背景的标准制定至关重要。联邦政府应该与公共机构、学术和私营企业一起协作制定出衡量人工智能产品和应用安全性的标准。

在没有监管的情况下,联邦政府也有切实可行的方式促进人工智能的创新。比如,政府拥有数千种不同的数据集,这些数据集对研究人工智能的研究人员和执行任务的机构来说非常有用。这些数据集中许多都是公共产品,应该向公众开放。

因此,参议院应努力通过众议院去年通过的“开放政府数据法案(OGDA)”。OGDA允许所有非敏感政府数据免费向公众开放。听证会上,研究人员称通过更加开放的数据政策,可用加强AI的发展。如果参议院通过了OGDA,总统应尽快签署成为法律,而主管机关应尽快实施。

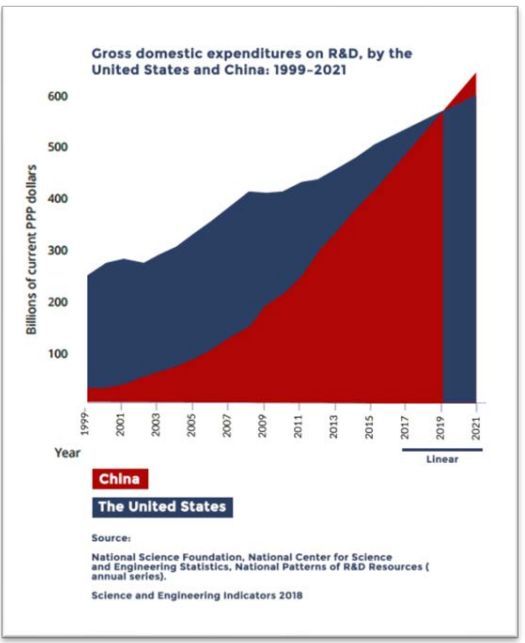

听证会上普遍支持的另一项建议是为研发提供更多的经济支持。大学和非营利机构进行的研究以及企业的研发工作是美国成为人工智能领导者的主要原因。为了保持美国在AI领域的领导地位,需要增加国家科学基金会、国立卫生研究院、国防高级研究项目机构、情报高级研究项目机构、国家标准与技术研究所、国土安全部、国家航空航天局等机构的研发资金。因此,建议联邦政府规定稳步增加联邦在AI研发领域的支出。增加资助的另一个好处是能够招募和支持更多的研究生,库卡机器人,这些研究生将构成未来AI领域的主要人才。